Kritik und Chancen Künstlicher Intelligenz in der politischen Bildungsarbeit

von admin

Dieser Beitrag erschien in der Fachzeitschrift der politischen Jugend- und Erwachsenenbildung 3/24 „Außerschulische Bildung„, herausgegeben vom Arbeitskreis deutscher Bildungsstätten.

In diesem Beitrag wird argumentiert, dass sich politische Bildung in Zeiten umfassender Digitalisierung hin zu einer kritischen Medienbildung entwickeln muss. Die gesellschaftlichen Auswirkungen neuerer Entwicklungen im Feld der Künstlichen Intelligenz werden beleuchtet und es wird gezeigt, mit welchen Fragen politische Bildung sich dem Thema annehmen muss: Inwiefern ist Technik politisch? Wie viel Mensch steckt in Künstlichen Intelligenzen? Unter welchen Bedingungen weiß die KI, was sie weiß? Wer hat Zugang zu KIs? Wie stehen digitale Technologien und gesellschaftliche Transformation in Beziehung zueinander? Fragen wie diese erlauben es, neue Technologien im Rahmen unserer Arbeit nicht nur zu nutzen, sondern auch deren Einfluss auf Demokratie und Privatsphäre kritisch zu bewerten und zu vermitteln.

Von Dr. Alev Coban, Katrin Hünemörder, Serkan Ünsal

Diskriminierung, Verschwörungserzählungen und die Ausbeutung von Arbeitenden haben zwar ihren Ursprung in der analogen kapitalistischen Welt, erfahren jedoch durch digitale Technologien wie Künstliche Intelligenz (KI) eine schnellere Verbreitung und Intensivierung. Wir sind der Meinung, dass genau das Spannungsfeld zwischen den Risiken Künstlicher Intelligenz, beispielsweise der Kommerzialisierung persönlicher Daten, exkludierenden Zugängen und der Verbreitung demokratiefeindlicher Ideologien und Desinformation, und den Chancen von KI zur gesellschaftlichen Teilhabe und politischer Meinungsbildung ein Diskussionsraum eröffnet, der für die politische Bildung fruchtbar gemacht werden muss. Das bedeutet für eine kritische Medienbildung in Bezug auf KI dreierlei: 1) ein Verständnis der technischen Funktionsweise von KI zu vermitteln, 2) die politische Dimension von digitalen Mechanismen wie Algorithmen zu analysieren und 3) das Aneignen und die partizipative Mitgestaltung von neuen Technologien und Anwendungen zu fördern.

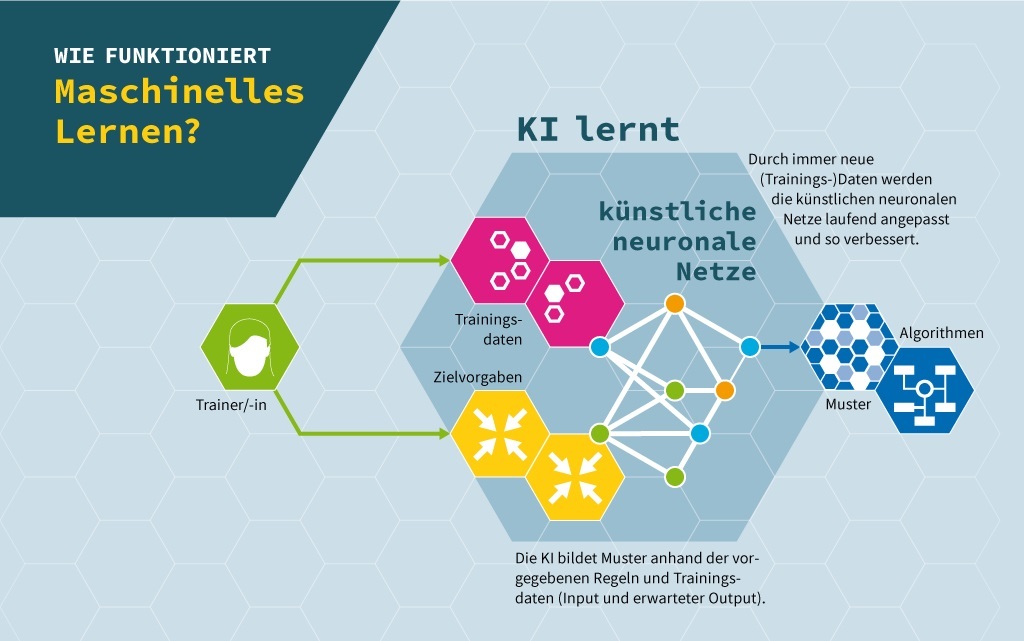

Die Relevanz der Auseinandersetzung mit Künstlichen Intelligenzen in der politischen Bildungsarbeit ist einfach zu erklären: KI umgibt uns schon heute fast überall, sodass Beziehungen zu diesen Technologien alltäglich geworden sind. Daher betrachten wir in unserer medienpädagogischen Arbeit vor allem KIs aus dem Alltag, wie beispielsweise Chatbots, mit denen wir interagieren und Wissen strukturieren, Emotions- und Verhaltenserkennungssoftware, die über Kameras helfen, Menschen einzuordnen, oder Empfehlungsalgorithmen im Onlinehandel, bei Streaming-Diensten und in sozialen Netzwerken, die User*innen personalisierte Inhalte und Produkte vorschlagen. Wir fokussieren in diesem Artikel also Künstliche Intelligenzen, die Machine-Learning-Modelle sind. Das heißt, wir analysieren die politische Dimension von algorithmischen Systemen, die mit großen Mengen an Daten trainiert werden und darauf aufbauend Regelmäßigkeiten erkennen (vgl. Ulbrich/Braun Binder 2023). Solche Künstliche Intelligenzen wissen zunächst nicht, wie sie eine Aufgabe lösen können, sondern finden dies erst im Lernprozess durch die Wahrscheinlichkeit der richtigen Antwort heraus. Auf Grund dieser als revolutionär betrachteten Eigenschaft werden solche KIs selbstlernende Systeme genannt.

Um die politischen Dimensionen von KI zu verstehen und zu hinterfragen, müssen zentrale Themen wie Macht, Ökonomie, Nachhaltigkeit, Digitalisierung und Medien analysiert werden. Im Folgenden beleuchten wir daher die Ausbeutungsverhältnisse in der Entwicklung von KIs, die diskriminierenden Effekte und den fragmentierten Zugang zur Entwicklung und Nutzung von KIs und formulieren Fragen für die gemeinsame Erörterung in pädagogischen Kontexten.

Inwiefern ist Technik politisch?

Um uns neuen Technologien machtkritisch zu nähern, braucht es ein Verständnis dafür, dass technologische Innovationen in kapitalistischen Gesellschaften als wertvolle Treiber ökonomischen Wachstums und nationaler Vormachtstellung und als Lösungen für strukturelle Probleme wie Armut gesehen werden. Die Einsicht, dass Innovationen vermeintlich universelle Lösungen gesellschaftlicher Herausforderungen darstellen, hilft uns, über die beiden Auswirkungen dieses kapitalistischen Fortschrittverständnisses zu sprechen: erstens, die Entpolitisierung struktureller Probleme (vgl. Arora/Romijn 2011) und zweitens, die Schaffung konservativer Zukunftsbilder und Technologien (vgl. Ames 2015, S. 115). Die Verwobenheit von Technologien und westlichem Fortschrittsglauben zeigt, dass neue Technologien wie Künstliche Intelligenzen politisch sind. Daher plädieren wir im Folgenden, auch die Auswirkungen von KI in den Blick zu nehmen.

Grundlage der politischen Bildung zu Künstlichen Intelligenzen sollte die Demystifizierung von Technologien sein: KIs sind keine autonom agierenden Systeme, die die Menschheit unterjochen, aber auch keine neutralen Werkzeuge, die uns Menschen bloß den Alltag erleichtern oder gar die Arbeit abnehmen. Ziel der Frage „Wie viel Mensch steckt in Künstlichen Intelligenzen?“ ist die Sichtbarmachung kapitalistischer Verwertungslogiken, in die KIs eingebettet sind. Das bedeutet, im Vordergrund der Bildungsarbeit sollte die Vermittlung der menschlichen Arbeit hinter und mit KIs stehen und deren Auswirkungen auf Nutzer*innen und die Gesamtgesellschaft.

Entwicklung Künstlicher Intelligenz: die politische Ökonomie des Digitalen

Es ist wichtig zu wissen, wie KI entwickelt wird, um deren politische Wirksamkeit zu verstehen: Technikentwickler*innen stellen der KI eine große Menge an Daten zur Verfügung, anhand derer sie Regelmäßigkeiten findet. Diese sogenannten Trainingsdaten helfen der KI zu lernen, wie sie eine ihr gestellte Aufgabe lösen kann. Das Wissen über den Trainingsprozess von Algorithmen lässt den oft unsichtbar bleibenden Hintergrund von Künstlichen Intelligenzen durchscheinen: die politische Ökonomie des Digitalen oder spezifischer ausgedrückt, die sozio-materiellen Grundlagen, wie Arbeit und Kapital, die benötigt werden, um KIs zu entwickeln. In Bildungsprozessen können wir also mit der Frage „Unter welchen Bedingungen weiß die KI, was sie weiß?“ einen Blick auf den Hintergrund der Trainingsdaten, die dafür benötigte menschliche Arbeit und deren Ausbeutung werfen.

Ein vielfach analysiertes Beispiel der Arbeit hinter KIs ist die erste Crowdworking-Plattform namens Amazon Mechanical Turk[1] (vgl. Irani/Silberman 2013). Amazon gründete diese Plattform 2005, um niedrigschwellige, kleinteilige und zeitlich begrenzte Aufträge an nicht-angestellte digitale Arbeiter*innen weltweit zu bringen (vgl. Altenried 2017, S. 178). Großkonzerne oder Start-Ups mit hohen Investitionen verwenden Plattformen wie Amazon Mechanical Turk, um die benötigten Massen an gleichförmigen Trainingsdaten von einer „Crowd“ an digitalen Arbeiter*innen herstellen zu lassen (vgl. Schmidt 2019, S. 62). Beispielsweise wurde durch solche Arbeit Künstliche Intelligenz zum maschinellen Lesen von gescannten Texten trainiert: Crowdworker*innen transkribierten unzählige Visitenkarten und die Texte eingescannter Bücher, um Trainingsdaten herzustellen und verrichteten somit eine digitale Dienstleistung, die damals menschengemacht billiger als die Arbeit von künstlichen neuronalen Netzwerken war (vgl. ebd., S. 11).

Produzent*innen von KI-Trainingsdaten loben einerseits den relativ leichten Zugang zur digitalen Arbeit: Crowdworker*innen in Venezuela berichten, dass sie sich selbstermächtigt fühlen, da sie als Teil einer globalen Community arbeiten können und nicht weiter exkludiert vom Weltmarkt sind (vgl. ebd., S. 60 f.). Andererseits ist Plattformarbeit prekär, da sie nur in selbständiger Form ausgeführt werden kann. Die Nicht-Anstellung der Arbeiter*innen unterläuft die Mindestlöhne vieler Länder und führt somit zur Unterbezahlung von Crowdworker*innen (vgl. Irani/Silbermann 2013, S. 612). Des Weiteren sind die Arbeiter*innen durch ihre niedrigschwelligen Arbeitsaufgaben relativ leicht austauschbar (vgl. Schmidt 2019, S. 62).

Es lässt sich also sagen, dass die Bedingungen unter denen eine KI weiß, was sie weiß, zumeist privatwirtschaftlich strukturiert sind: Um den Profit von großen Tech-Konzernen oder hochdotierten Start-Ups höher zu treiben, stecken prekäre Beschäftigungsverhältnisse hinter dem Trainieren von KIs oder sogar unbezahlte unwissentliche Arbeit von Internet- und Social Media-Nutzer*innen, deren Daten aus recommender Systemen oder Softwares wie reCAPT-CHA von Google verwendet werden, um proprietäre gewinnorientierte Algorithmen zu trainieren (vgl. Nachtwey/Schaupp 2022; Pfeiffer 2021; Terranova 2000).

Auswirkungen Künstlicher Intelligenz: Konservative Normierung von Gesellschaft

Technologien, wie auch Künstliche Intelligenzen, sind niemals losgelöst von gesellschaftlichen Strukturen, denn sie werden von Menschen gemacht und trainiert. Vor allem in der Anwendung komplexer KIs ist die Reproduktion gesellschaftlicher Ungleichheiten in Form von Rassismus, Sexismus und Ableismus erkennbar. Beispiele hierfür wären die Algorithmen von Kredit-Scoring-Systemen, die die Kreditwürdigkeit von Personen am Wohnort oder der Schulbildung ausmachen, sogenanntes Predictive Policing, also der Vorhersage von Kriminalität in immergleichen Stadtteilen durch Algorithmen der Polizei (vgl. Jefferson 2018; Kaufmann et al. 2019), Werbealgorithmen von Facebook, die stereotype Adressierungen nach Gender vollführen (vgl. Kayser-Bril 2020) oder Emotionserkennungstechnologien, die mit Überwachungskameras nach auffälligem Verhalten suchen.

Algorithmen wirken diskriminierend, da sie durch ihre Trainingsdaten oft einen Bias besitzen und durch Kategorien wie ein vermeintlich „normales“ Verhalten und Aussehen oder einer „guten“ Schulbildung und Wohnlage Entscheidungen treffen. So verfestigen sich scheinbar „gewöhnliche“ Verhaltensmuster oder Körpernormen der Dominanzgesellschaft und etablieren eine herrschende Norm. Zum Beispiel werden Menschen mit Sehbehinderungen diskriminiert, wenn eine KI das Verhalten einer sehenden Mehrheit als richtig erachtet. Auch Schwarze Menschen und People of Color (BPoC) werden von algorithmischen Systemen diskriminiert, indem sie die Gesichter und Gesichtszüge von BPoC oft nicht korrekt erkennen oder mit falschen Emotionen auswerten (vgl. Birhane 2022). Aufgrund dieser diskriminierenden Normierung von Menschen als weiß, männlich und nichtbehindert bezeichnet Zajko (2021) algorithmische Mechanismen als konservativ. Er meint damit, dass tradierte Normen, wie Menschen zu sein haben, wiederholt werden und somit unsere gesellschaftliche Zukunft unveränderbar scheint, also konservativ gestaltet wird.[2]

Künstliche Intelligenzen sind also keine objektiven und neutralen Technologien, sondern sind abhängig von der Qualität und vor allem der Diversität ihrer Trainingsdaten. Somit können wir Technikentwicklung an sich, aber auch die Auswirkungen von Künstlicher Intelligenz, immer als politisches Phänomen verstehen und vor allen Dingen dort hinterfragen, wo Technologie marginalisierte Menschen ausschließt und diskriminiert.

Der Zugang zu der Entwicklung und Nutzung Künstlicher Intelligenz ist nicht nur eine Frage der technischen Verfügbarkeit, sondern auch sozialer, ökonomischer und politischer Faktoren wie technischer Infrastruktur, Bildung und wirtschaftlichen Ressourcen. Da diese in vielen Regionen oft fehlen, ist der Zugang zu KI in der Regel auf wohlhabende und urbanisierte Regionen beschränkt.

So zeigt eine Studie, dass der Zugang zu KI in indischen Schulen hauptsächlich auf Schüler*innen in urbanen und wohlhabenden Gebieten beschränkt bleibt, während ländliche und wirtschaftlich benachteiligte Gebiete oft exkludiert sind (vgl. Vazhayil et al. 2023, S. 74). Die Kluft in der Anwendung zeigt sich auch in Regionen des Globalen Nordens, in denen Schüler*innen aus Städten einen erheblichen Vorteil beim Zugang zu KI-Lernwerkzeugen im Vergleich zu ländlichen Regionen haben (vgl. Smith/Brown 2023, S. 23). Dieser ungleiche Zugang wird weiter verdeutlicht durch die Tatsache, dass generative KI-Werkzeuge wie ChatGPT hauptsächlich von Einzelpersonen und Organisationen mit finanziellen Ressourcen und technischem Fachwissen genutzt werden können (vgl. Pavlik 2023, S. 86). Das bedeutet, der Zugang zu KI ist oft von den verfügbaren finanziellen Mitteln und dem bildungspolitischen Willen abhängig (vgl. Smith/Brown 2023, S. 19).

Der exklusive Zugang zu KI-Anwendungen ist eng mit gesellschaftlichen Machtstrukturen verknüpft. In marginalisierten Gemeinschaften spiegelt der Mangel an Zugang zu KI gesellschaftliche Ungleichheiten wider, die häufig tief in bestehenden sozialen Hierarchien verwurzelt sind, wobei Geschlecht, soziale und regionale Herkunft eine bedeutende Rolle dabei spielen, wer Zugang zu diesen Technologien hat und wer nicht (vgl. ebd., S. 25). Eine intersektionale Perspektive hilft, die unterschiedlichen Ebenen von Diskriminierung und Privilegien zu verstehen, die den Zugang zu KI-Technologie beeinflussen. Sie berücksichtigt, wie miteinander verschränkte gesellschaftliche Marginalisierungen die Erfahrungen und die Zugänge zu technologischen Möglichkeiten bedingen (vgl. Vazhayil et al. 2023, S. 75).

Auch in sozialen Netzwerken und anderen digitalen Räumen zeigt sich die Verschärfung ungleicher Zugangsvoraussetzungen deutlich: Soziale Medienalgorithmen verstärken oft Inhalte von dominanten Gruppen, was zu einer ungleichen Verteilung von Wissen und Ressourcen führt (vgl. Pavlik 2023, S. 89). Ein konkretes Beispiel ist die bevorzugte Verbreitung von Beiträgen großer Medienunternehmen und einflussreicher Einzelpersonen, während Beiträge von Aktivist*innengruppen – insbesondere solche aus marginalisierten Gemeinschaften – häufig weniger Sichtbarkeit erhalten. Dies kann zu einer verzerrten Wahrnehmung der Nutzer*innenschaft führen und bestehende soziale Ungleichheiten verstärken, indem die Sichtbarkeit und Beteiligung von marginalisierten Gruppen im digitalen Raum eingeschränkt wird (vgl. Allen/Kendeou 2023, S. 22; Kumar/Gupta 2024, S. 34).

Politisch-bildnerische Ansätze im Kontext von KI sollten deshalb speziell darauf ausgerichtet sein, strukturell marginalisierte Menschen zu unterstützen und ihnen die notwendigen Werkzeuge und Fähigkeiten zu vermitteln, um aktiv an digitalen Prozessen und Foren zur Meinungsbildung teilzunehmen (vgl. Smith/Brown 2023, S. 26).

Wie beeinflusst KI demokratische Strukturen?

Algorithmische Systeme in sozialen Netzwerken beeinflussen Prozesse politischer Meinungsbildung und die Verbreitung von Informationen in der digitalen Welt. Für die politische Bildungsarbeit ist es daher essentiell, diese Mechanismen besonders in Augenschein zu nehmen, da vor allem gezielte Desinformation das Vertrauen in politische und demokratische Strukturen erheblich untergräbt. KI-generierte Inhalte wie sogenannte deep fakes, die kaum noch von real existierenden Inhalten zu unterscheiden sind, tragen zu Verunsicherung und Vertrauensverlust gegenüber medialen Informationen bei. Populistische und rechtsextreme Akteur*innen nutzen gezielt algorithmusgesteuerte Funktionen sozialer Medien, um emotionalisierende und komplexitätsreduzierende Botschaften zu verbreiten. Diese viral verbreiteten Inhalte können den Eindruck erwecken, dass sich der gesellschaftliche Diskurs verändert hat und somit zur Destabilisierung von demokratischen Strukturen beitragen. Der problematische Aspekt liegt nicht nur in der Technologie selbst, sondern vor allem in gesellschaftlichen Einstellungen wie Rassismus oder Antisemitismus, die durch die schnelle, unkontrollierbare und nicht-lineare Verbreitung verstärkt werden.

Transformative Bildung für die Demokratisierung von KI

KI und gesellschaftliche Transformationsprozesse scheinen in einer interaktiven Beziehung zueinander zu stehen. Jarke et al. (2024) analysieren, dass sich moderne demokratische Gesellschaften in algorithmische Regime verwandeln, da Algorithmen zur zentralen Technologie für die Erstellung, Bewertung und Verbreitung von Wissen in verschiedenen gesellschaftlichen Bereichen geworden sind und sich damit Wahrheitsansprüche verändert haben. Das bedeutet, dass politische Entscheidungen, denen gesellschaftliche Aushandlungsprozesse zugrunde liegen sollten, immer mehr durch Algorithmen beeinflusst werden, wie in den oben genannten Beispielen zu Überwachung, Kontrolle oder Diskriminierung durch staatliche und private Akteure bereits deutlich geworden ist. Algorithmische Systeme ermöglichen jedoch auch neue Formen der partizipativen Wissensproduktion und -verbreitung, die wir uns in einer handlungsorientierten politischen Medienbildung zu eigen machen können.

Wir verstehen politische Bildung als transformative Bildung, die nicht nur Wissen vermittelt, sondern auch Handlungsmöglichkeiten hin zu emanzipatorischen gesellschaftlichen Transformationen eröffnen soll. Somit versuchen wir, gemäß der Frankfurter Erklärung (2015), „… eine ermutigende Lernumgebung, in der Macht- und Ohnmachtserfahrungen thematisiert und hinterfragt werden” zu schaffen, um Teilnehmende zu befähigen, Teilhabe auch an Technickentwicklungsprozessen einzufordern. Unsere These ist: Je partizipativer Technologien entwickelt werden, desto größer ist die Chance, dass sie für mehr Menschen funktionieren und positive Auswirkungen haben (vgl. Aktion Mensch e. V./SINUS-Institut 2020). Das bedeutet, dass wir die technische Funktionsweise von KI und auch die politische Dimension von algorithmischen Systemen vermitteln, um dann die Handlungsoptionen der Aneignung und der partizipativen Mitgestaltung von neuen Technologien zu eröffnen.

Damit Menschen mündig mit Künstlichen Intelligenzen interagieren können, braucht es vor allem Datenkompetenz, sogenannte data literacy. Hierbei besteht die Herausforderung für Pädagog*innen, komplexe und schwer zu verstehende technische Inhalte selbst nachzuvollziehen und anschließend möglichst niedrigschwellig zugänglich zu machen. Wir wenden in diesem Zuge experimentelle Ansätze an, bei denen Jugendliche eigene Daten generieren, diese analysieren und visualisieren oder sogar eine eigene KI entwickeln, um zu erforschen, wie unterschiedlich sich Künstliche Intelligenzen verhalten, wenn sie mit verschiedenen Trainingsdaten gefüttert werden (vgl. Behrendt in dieser Ausgabe, S. 64 ff.). Solche Experimente ermöglichen es, KI-Entscheidungsfindungsprozesse und deren Kategorisierungen von Daten zu erkunden und zu verstehen, welche Datensätze notwendig sind, um diskriminierungsarme Entscheidungen der KIs zu ermöglichen. Außerdem erkenntnisbringend ist der Versuch des reverse engineerings, also auszuprobieren, die Funktionslogiken von bestehenden KIs zu verstehen. Das baldige Scheitern, beispielsweise die Algorithmen von TikTok technisch nachzuvollziehen, zeigt, dass KI-Technologien vorrangig im privatwirtschaftlichen Sektor entstehen und somit Entscheidungsprozesse von proprietärer KI für die Zivilgesellschaft intransparent und unzugänglich bleiben.

Neben den Erkenntnissen zur technischen Funktionsweise und politischen Ökonomie von Künstlichen Intelligenzen, gehört unserer Meinung nach auch die Technikfolgenabschätzung zu einer kritischen Medienbildung. Wenn wir davon ausgehen, dass die Entwicklung von Technologien grundsätzlich politische Implikationen hat, ergibt sich die Notwendigkeit, sich mit den Auswirkungen von KI auseinanderzusetzen und zugehörige ethische Fragen in Bildungsprozesse zu integrieren. Eine zentrale Fragestellung wäre, wie KI gestaltet sein muss, damit sie für möglichst viele Menschen gut funktioniert und nicht nur für einen kleinen, von Partikularinteressen getriebenen Teil der Gesellschaft, der das Wissen und die Ressourcen hat, um Technologien im eigenen Sinne und nicht notwendigerweise zum Wohle der Allgemeinheit zu entwickeln. Häufig entwickeln Teilnehmende im Rahmen unserer Bildungsangebote deshalb eigene gesellschaftliche Utopien, um sich dann zu überlegen, welche technologischen Innovationen es braucht, um einzelne Aspekte der Utopien umzusetzen oder weiterzuentwickeln.

Transformative Bildung begleitet die Teilnehmenden letztendlich auch bei der Entwicklung von Forderungen an die Politik, an andere Entscheidungsträger*innen und Technikentwickler*innen zur Demokratisierung digitaler Räume durch eine demokratische Beteiligung in Entscheidungsprozessen über die Entwicklung und den Einsatz Künstlicher Intelligenz.

Fazit: Kritische Medienbildung für eine emanzipatorische Transformation

Digitale Mündigkeit und Datenkompetenz sind die Schlüssel, um Kinder und Jugendliche, aber auch Erwachsene dabei zu unterstützen, eigene Haltungen zu algorithmischen Systemen zu entwickeln und Methoden der politischen Selbstwirksamkeit in digitalen Räumen anwenden zu können. In einer kritischen Medienbildung zu KI soll es also nicht nur darum gehen, die potenziellen Gefahren zu diskutieren, sondern auch die vielfältigen Chancen und Handlungsoptionen, die Künstliche Intelligenz und ihr Einsatz bieten. Durch das eigene Programmieren, Trainieren und Designen von KI kann eine emanzipatorische Praxis mit neuen Technologien geschaffen werden, um an einer solidarischen Gesellschaft mitzuwirken. Als Teil dieser emanzipatorischen Transformation sehen wir die digitale Zivilgesellschaft in der Verantwortung, darüber zu entscheiden, welche Technologien gesellschaftlich sinnvoll sind und in welchen Bereichen deren Einsatz unerwünscht ist, etwa aufgrund nicht absehbarer Auswirkungen, undemokratischer Praktiken oder diskriminierender Effekte. Daher sollten wir politische Medienbildner*innen uns für einen gerechten Zugang zu digitalen Räumen stark machen und für mehr Entwicklung von demokratisch legitimierten, offenen und gemeinwohlorientierten KI-Technologien.

Der Zeitpunkt für die Auseinandersetzung mit der ethischen und politischen Dimension von Künstlicher Intelligenz ist jetzt: Am 21. Mai 2024 verabschiedete der Europäische Rat sein Regelwerk zu Künstlicher Intelligenz. Im Rahmen dieser Verordnung werden KI-Technologien hinsichtlich ihres Risikos für eine Gesellschaft klassifiziert. KIs mit inakzeptablen Risiken sollen demnach verboten werden, das gilt für Systeme, die das Verhalten von Personen gezielt beeinflussen wollen, oder auch KI-basiertes Social Scoring, also die Vergabe von Punkten aufgrund von erwünschtem Verhalten. Allerdings bietet die KI-Verordnung nur Orientierung für die Klassifizierung bestehender Künstlicher Intelligenzen. Die gemeinnützige NGO AlgorithmWatch kritisiert verschiedene Schlupflöcher, zum Beispiel, dass Technikentwickler*innen ein Mitspracherecht in der Klassifizierung ihrer eigenen Systeme haben oder dass es staatliche Ausnahmen zur Verwendung von Hochrisikosystemen gibt, wenn die KIs für nationale Sicherheit, Strafverfolgung oder Migration eingesetzt werden (vgl. Müller/Spielkamp 2023). Da die KI-Verordnung innerhalb der nächsten zwei Jahre in nationales Recht umgewandelt werden muss, besteht jetzt die Notwendigkeit, im Rahmen von Beteiligungsprozessen die Zivilgesellschaft mit einzubeziehen und Forderungen nach gemeinwohlorientierter Künstlicher Intelligenz hervorzubringen.

Aktion Mensch e. V/SINUS-Institut (2020): Digitale Teilhabe von Menschen mit Behinderung: Trendstudie; https://aktion-mensch.stylelabs.cloud/api/public/content/AktionMensch_Studie-Digitale-Teilhabe.pdf?v=16179909 (Zugriff: 19.07.2024)

Allen, Ethan/Kendeou, Theofilos (2023): An Interdisciplinary Framework for AI Literacy in Education. In: Journal of Educational Technology 14(3), pp. 12–23

Altenried, Moritz (2017): Die Plattform als Fabrik: Crowdwork, digitaler Taylorismus und die Vervielfältigung der Arbeit. In: PROKLA 47(187), S. 175–192

Ames, Morgan G. (2015): Charismatic Technology. In: Proceedings of the Fifth Decennial Aarhus Conference on Critical Alternatives. Aarhus University Press, pp. 109–120

Arora, Saurabh/Romijn, Henny (2011): The Empty Rhetoric of Poverty Reduction at the Base of the Pyramid. In: Organization 19(4), pp. 481–505

Birhane, Abeba (2022): The unseen Black faces of AI algorithms. In: Nature 610, pp. 451–452

Frankfurter Erklärung (2015): Für eine kritisch-emanzipatorische Politische Bildung; https://akg-online.org/arbeitskreise/fkpb/frankfurter-erklaerung-fuer-eine-kritisch-emanzipatorische-politische-bildung.html (Zugriff: 17.06.2024)

Irani, Lilly/Silberman, M. Six (2013): Turkopticon: Interrupting worker invisibility in amazon mechanical turk. In: Proceedings of the SIGCHI conference on human factors in computing systems, pp. 611–620

Jarke, Juliane/Prietl, Bianca/Egbert, Simon/Boeva, Yana/Heuer, Hendrik/Arnold, Maike (Hrsg.) (2024): Algorithmic Regimes. Methods, Interactions, and Politics. Amsterdam: Amsterdam University Press

Jefferson, Brian Jordan (2018): Predictable Policing: Predictive Crime Mapping and Geographies of Policing and Race. In: Annals of the American Association of Geographers 108(1), pp. 1–16

Kaufmann, Mareile/Egbert, Simon/Leese, Matthias (2019): Predictive Policing and the Politics of Patterns. In: The British Journal of Criminology 59(3), pp. 674–692

Kayser-Bril, Nicolas (2020): Automatisierte Diskriminierung: Facebook verwendet grobe Stereotypen, um die Anzeigenschaltung zu optimieren; https://algorithmwatch.org/de/automatisierte-diskriminierung-facebook-verwendet-grobe-stereotypen-um-die-anzeigenschaltung-zu-optimieren (Zugriff: 17.06.2024)

Kumar, Priya/Gupta, Neha (2024): Introducing AI in School Curricula: Opportunities and Challenges. In: Journal of Technology in Education 9(1), pp. 31–36

Müller, Angela/Spielkamp, Matthias (2023): Einigung zum AI Act: Wichtiger Schutz und gefährliche Schlupflöcher; https://algorithmwatch.org/de/einigung-zum-ai-act-wichtiger-schutz-und-gefahrliche-schlupflocher (Zugriff: 10.07.2024)

Nachtwey, Oliver/Schaupp, Simon (2022): Ungleicher Gabentausch – User-Interaktionen und Wertschöpfung auf digitalen Plattformen. In: Kölner Zeitschrift für Soziologie und Sozialpsychologie74 (Suppl 1), S. 59–80

Pavlik, John V. (2023): Collaborating With ChatGPT: Considering the Implications of Generative Artificial Intelligence for Journalism and Media Education. In: Journalism & Mass Communication Educator 78(1), pp. 84–93

Pfeiffer, Sabine (2021): Digitalisierung als Distributivkraft – Über das Neue am digitalen Kapitalismus. Bielefeld: transcript Verlag

Schmidt, Florian A. (2019): Crowdproduktion von Trainingsdaten: Zur Rolle von Online-Arbeit beim Trainieren autonomer Fahrzeuge. Study der Hans-Böckler-Stiftung, No. 417

Smith, John/Brown, Emma (2023): Educational Programs and AI: A New Era of Learning. In: Educational Technology Review 18(2), pp. 19–27

Terranova, Tiziana (2000): Free Labor: Producing Culture for the Digital Economy. In: Social Text 18 – 2 (63), pp. 33–58

Ulbrich, Christian R./Braun Binder, Nadja (2023): Die grosse Verwirrung – KI und Automatisierung in Staat und Wirtschaft; www.nzz.ch/meinung/die-grosse-verwirrung-ki-und-automatisierung-in-staat-und-wirtschaft-ld.1729694 (Zugriff: 12.06.2024)

Vazhayil, Anu/Shetty, Radhika/Bhavani, Rao R./Akshay, Nagarajan (2023): Focusing on Teacher Education to Introduce AI in Schools: Perspectives and Illustrative Findings. In: Proceedings of the IEEE Tenth International Conference on Technology for Education, pp. 71–74

Zajko, Mike (2021): Conservative AI and social inequality: conceptualizing alternatives to bias through social theory. In: Ai & Society 36(3), pp. 1047–1056

[1]Amazon bezieht sich mit dem Namen Amazon Mechanical Turk auf den „Schachtürken“, auch als mechanischer Schachspieler aus dem 18. Jahrhundert bekannt und somit auf das Vortäuschen von maschineller Künstlicher Intelligenz durch versteckte Menschen (Schmidt 2019, S. 10). Es ist davon auszugehen, dass der diskriminierende Begriff „etwas türken“ aus der Fremdbezeichnung des Schachtürkens entstanden ist.

[2] Zum Thema „Diskriminierung durch KI“ hat die niedersächsische Landeszentrale für politische Bildung freie Bildungsmaterialien veröffentlicht, auf die wir an dieser Stelle sehr gerne verweisen: www.politische-medienkompetenz.de/unsere-schwerpunkte/kuenstliche-intelligenz/diskriminierung-durch-ki (Zugriff: 22.07.2024).